本次来做的是在windos下面配置idea的hdfs——java api的操作 基础代码 以及配置。

下载配置

首先我们先下载apache-maven-3.6.3

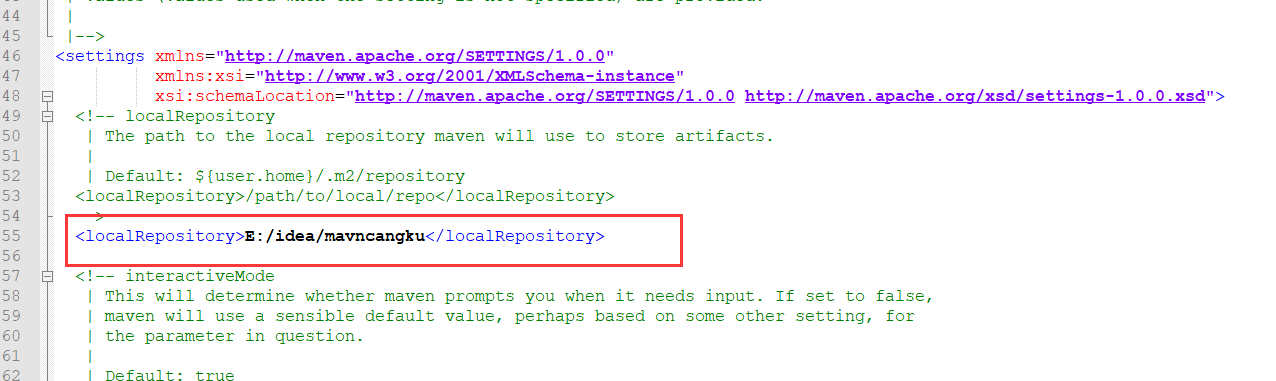

下载完成后配置 conf下面的settings.xml文件。

需要配置的有 {

- 仓库存在的路径

- 把仓库源改为国内阿里的

}

路径

阿里仓库

<!--阿里云仓库地址-->

<mirror>

<id>alimaven</id>

<name>aliyun maven</name>

<url>http://maven.aliyun.com/nexus/content/groups/public/</url>

<mirrorOf>central</mirrorOf>

</mirror>

<mirror>

<id>alimaven</id>

<mirrorOf>central</mirrorOf>

<name>aliyun maven</name>

<url>http://maven.aliyun.com/nexus/content/repositories/central/</url>

</mirror>

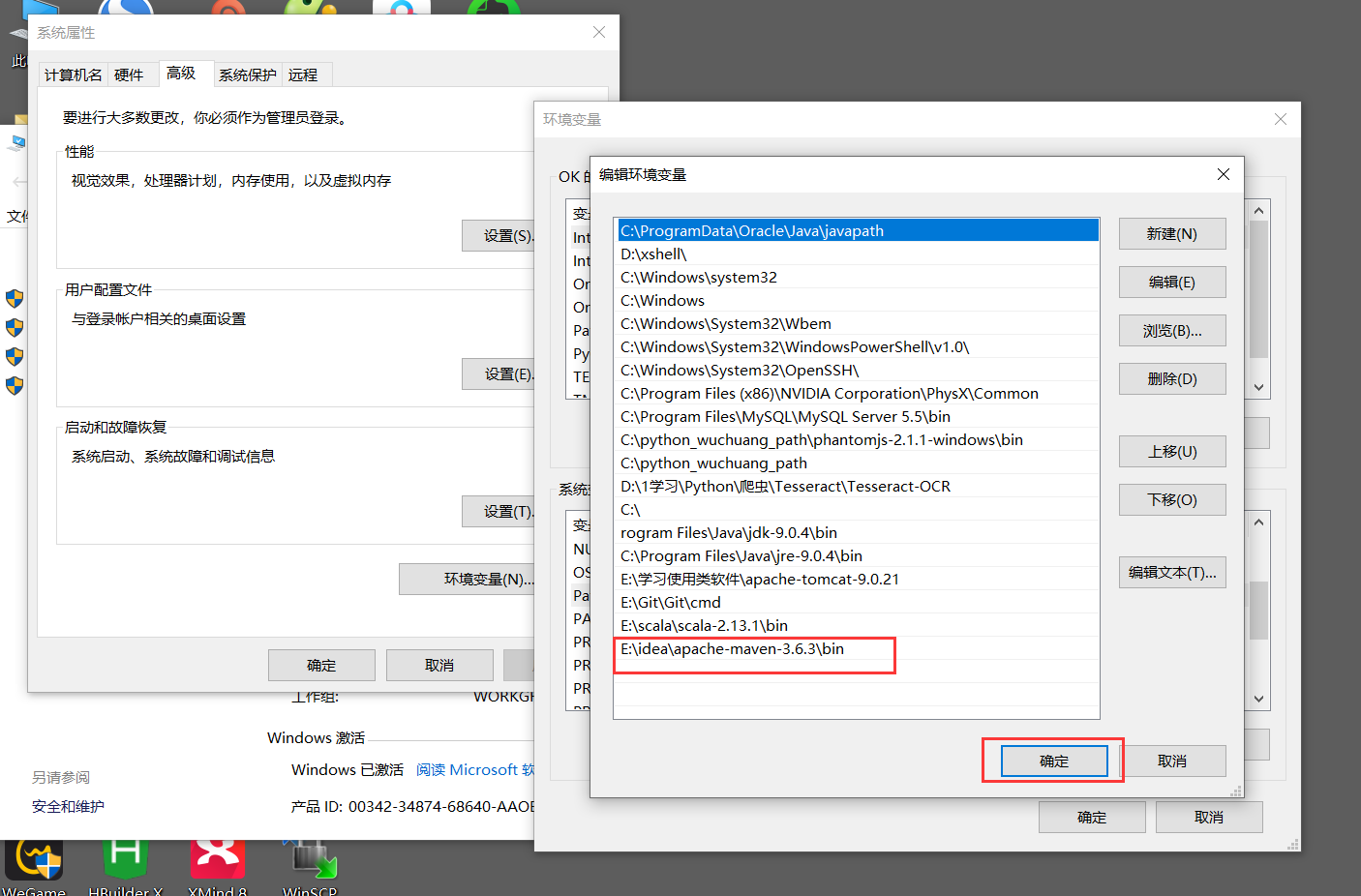

配置环境变量

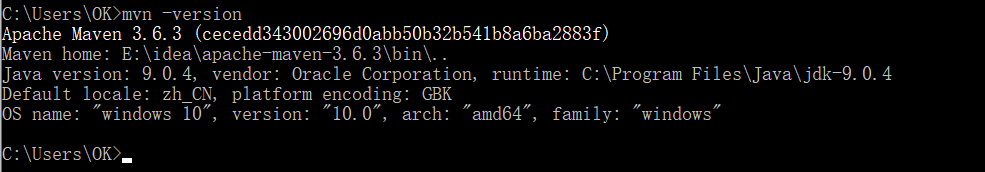

配置环境变量。配置完成后去dos窗口下运行看看能不能看到mvn -version的版本

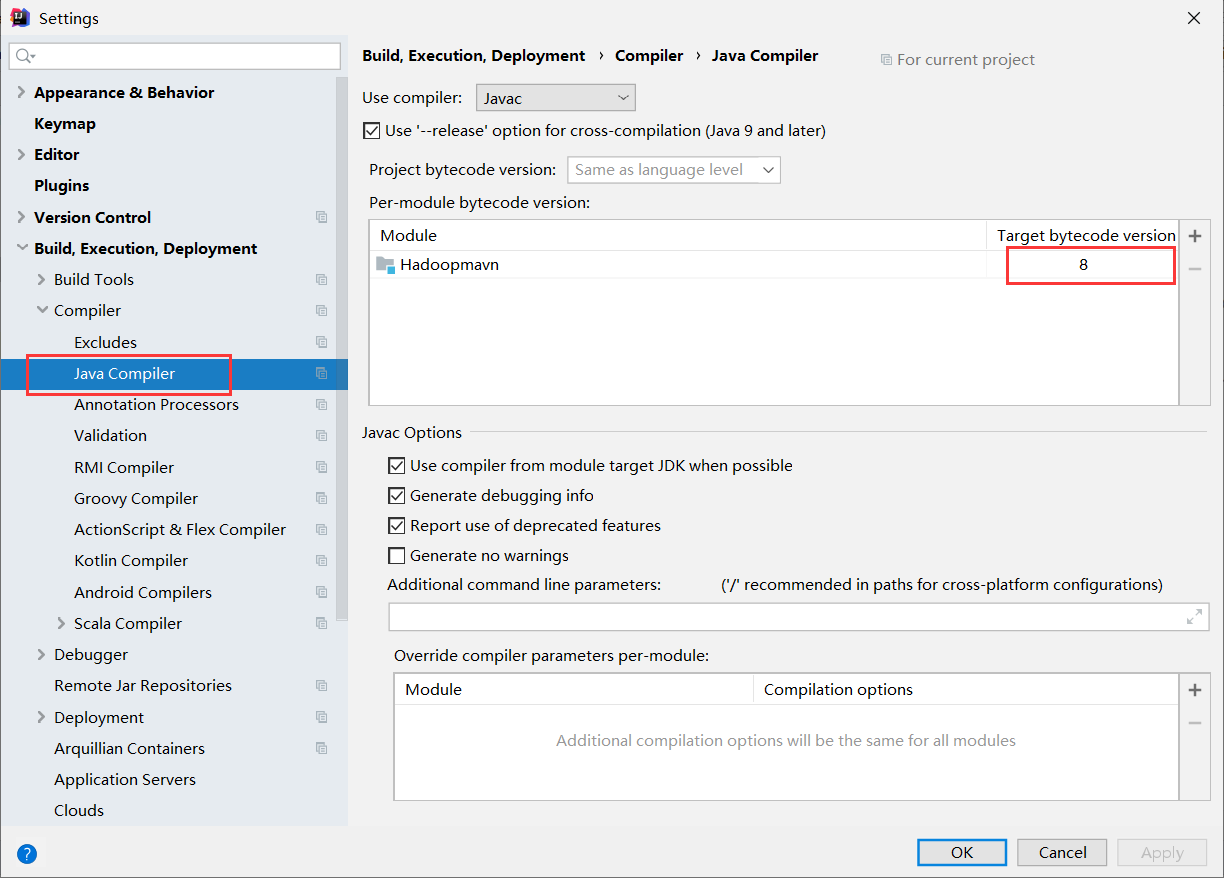

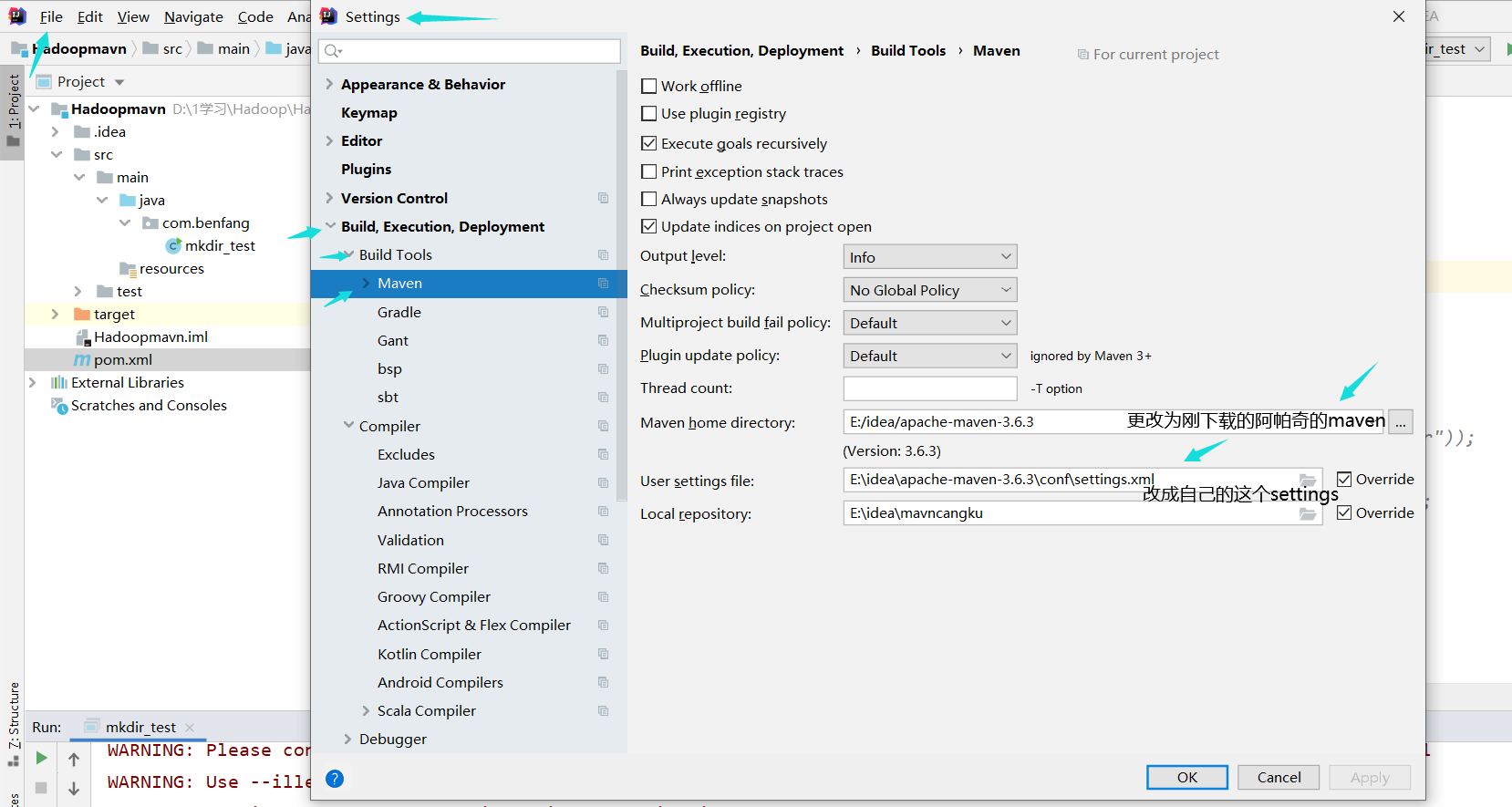

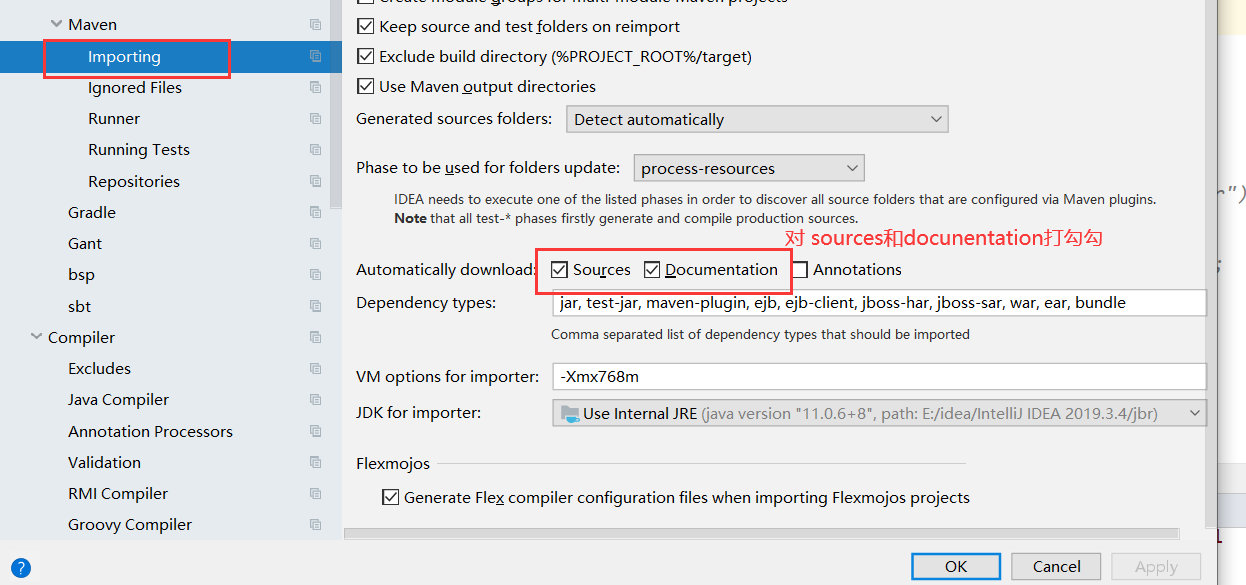

配置idea

图片上有说明安装这个配置,准没错。

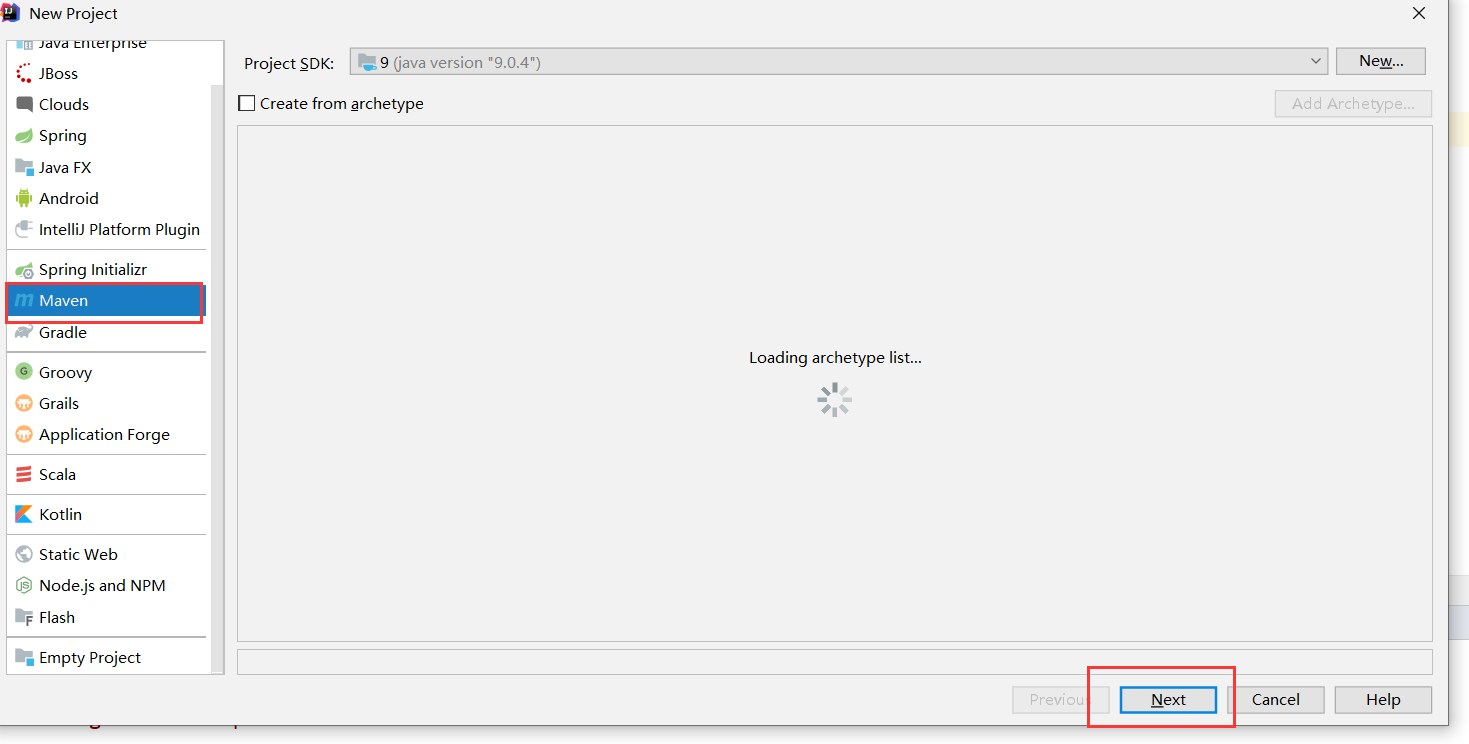

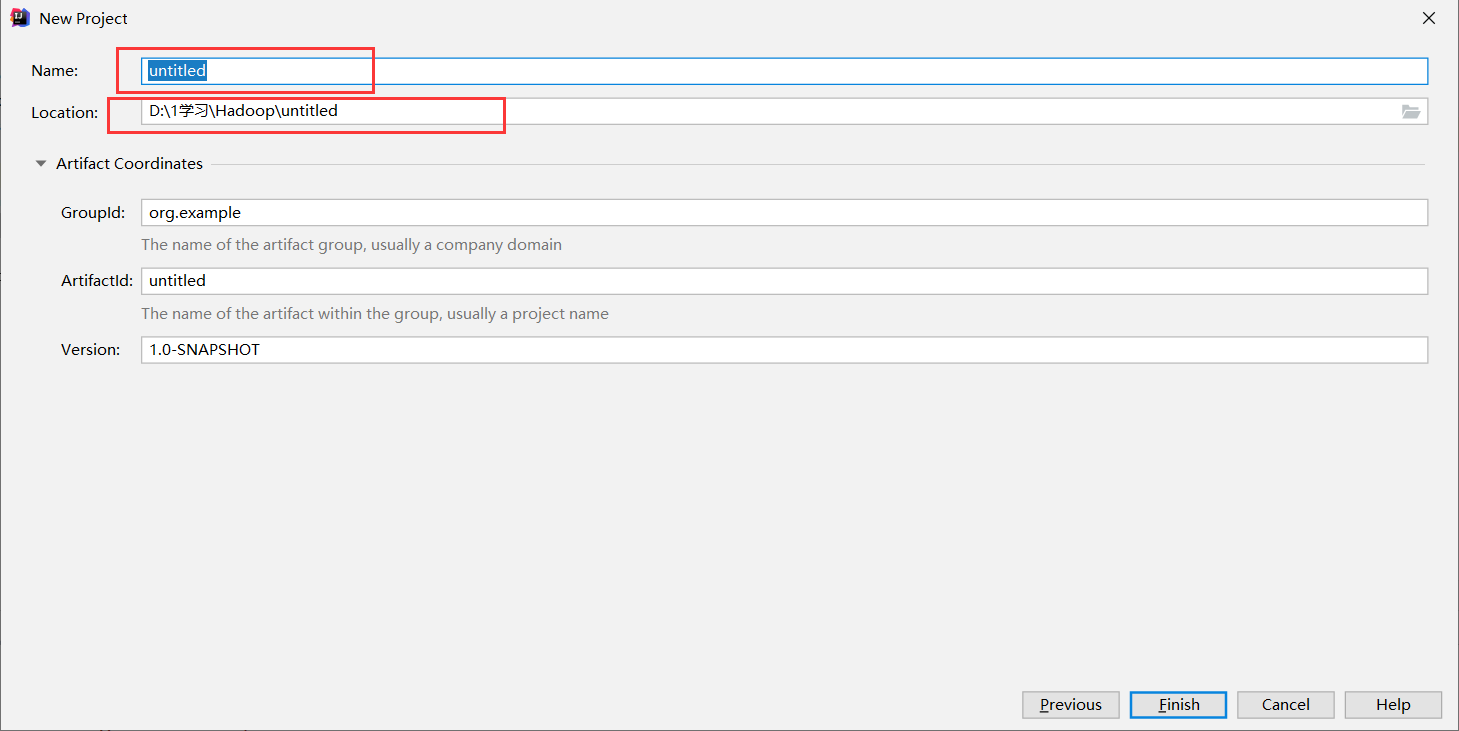

创建maven工程

点击next下一步。

填写好名称和路径之后就可以点完成了。

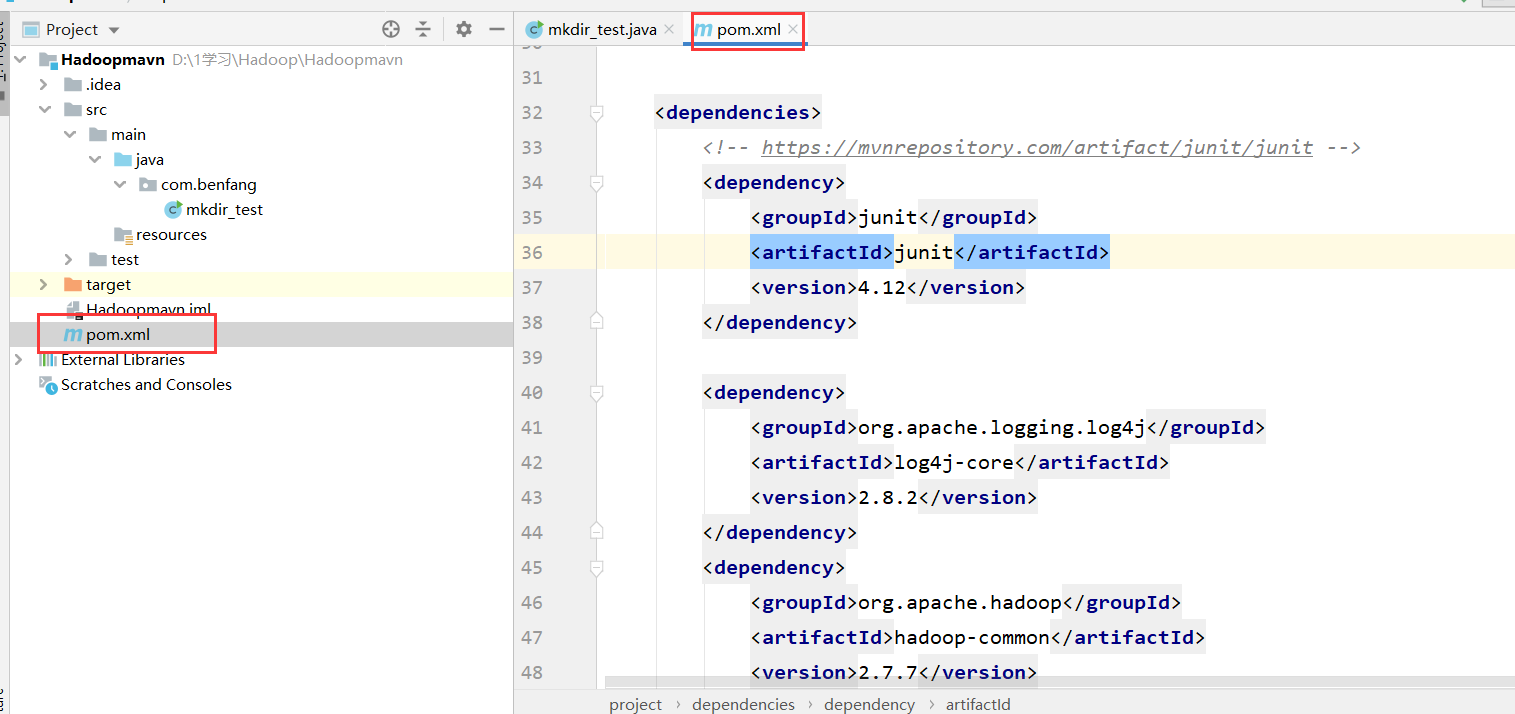

完成之后我们配置maven工程里的pom文件

网址: https://mvnrepository.com/

直接把需要的从这里拷贝走就可以用了。

这里我直接放代码吧。我用的是2.7.7版本的Hadoop所以配置的时候看准自己Hadoop的版本。

<dependencies>

<!-- https://mvnrepository.com/artifact/junit/junit -->

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.12</version>

</dependency>

<dependency>

<groupId>org.apache.logging.log4j</groupId>

<artifactId>log4j-core</artifactId>

<version>2.8.2</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.7.7</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.7.7</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-hdfs</artifactId>

<version>2.7.7</version>

</dependency>

</dependencies>

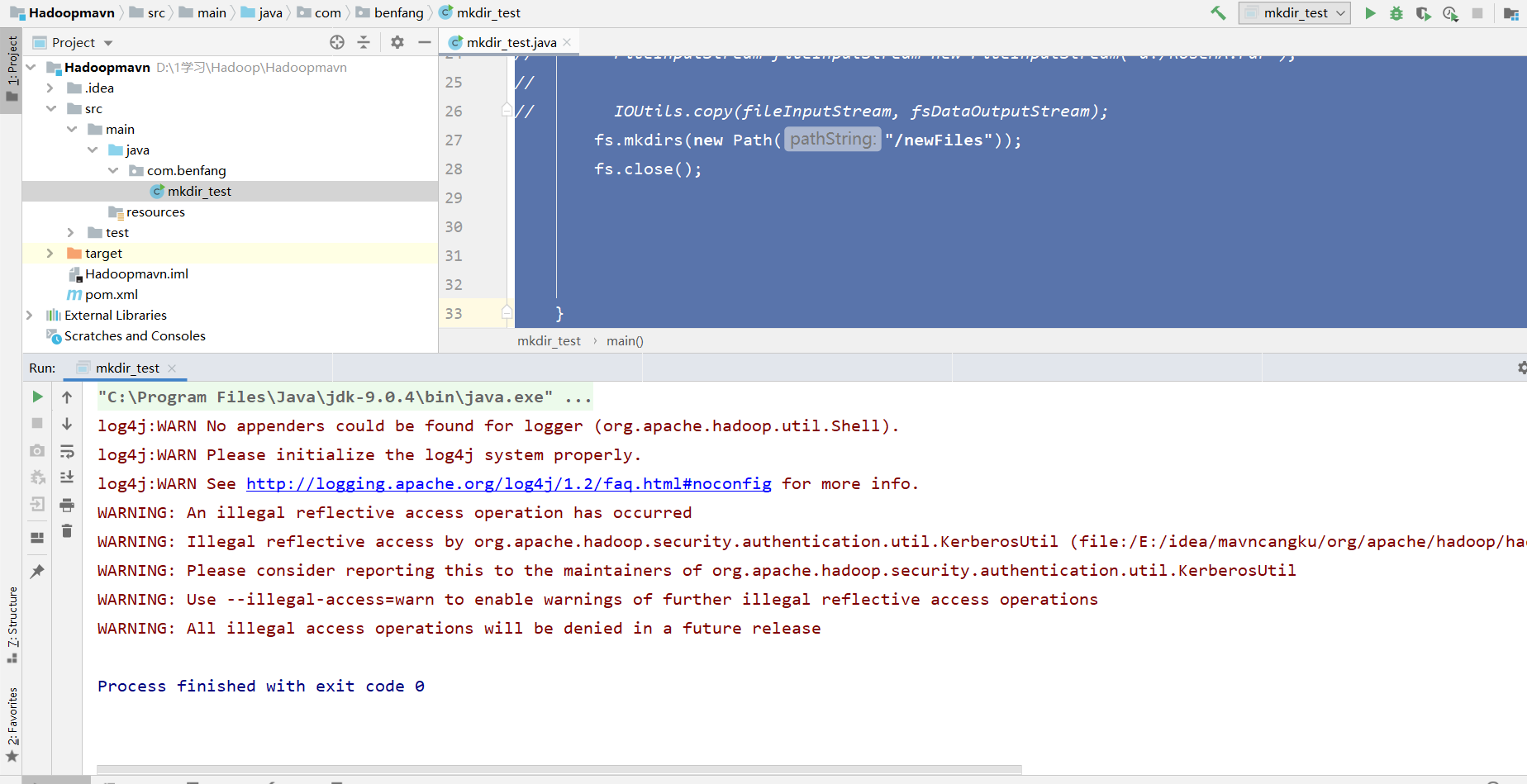

编写代码

配置完成之后我们去编写hdfsapi代码

在java文件夹里面创建一个包我又创建了一个类。

//创建在hdfs中的文件夹的代码。

package com.benfang;

import java.io.FileInputStream;

import java.io.IOException;

import org.apache.commons.io.IOUtils;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

public class mkdir_test {

public static void main(String[] args) throws IOException {

// TODO Auto-generated method stub

Configuration conf=new Configuration();

conf.set(“fs.defaultFS”, “hdfs://benfang4:9000”);

FileSystem fs=FileSystem.get(conf);

fs.mkdirs(new Path(“/newFiles”));

fs.close();

}

}

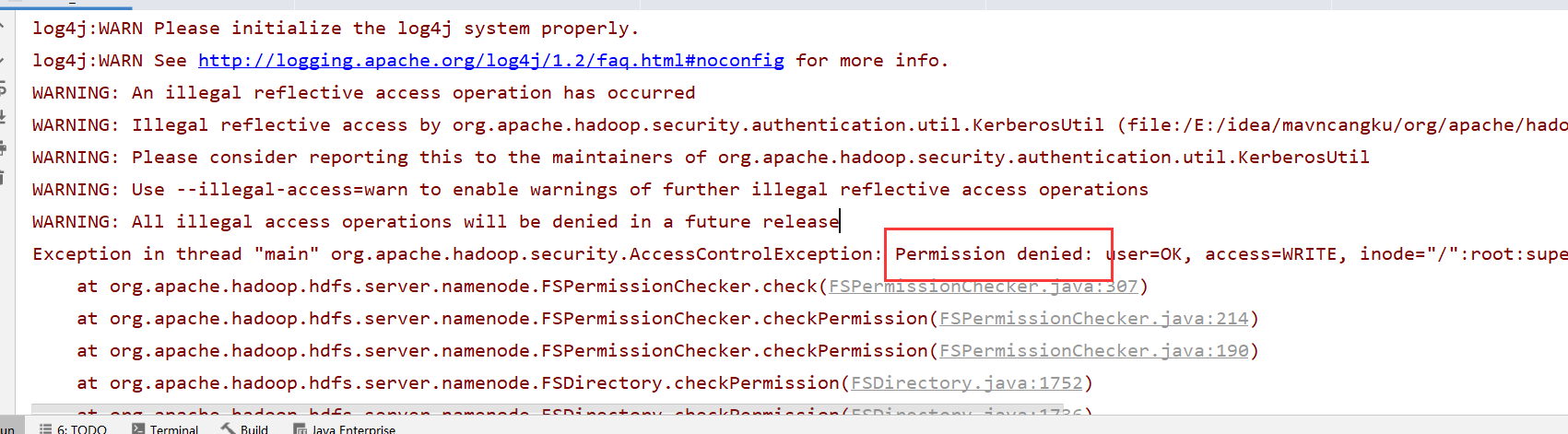

BUT

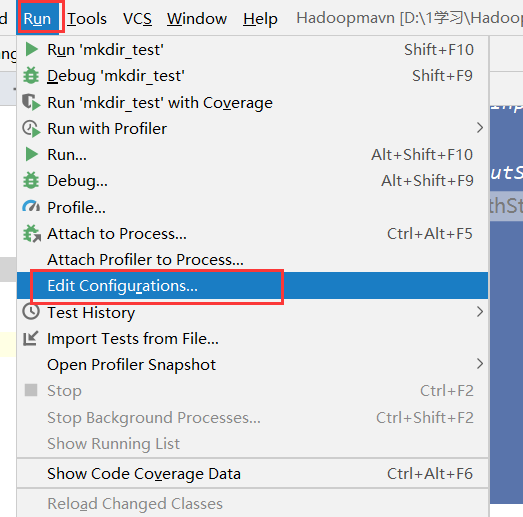

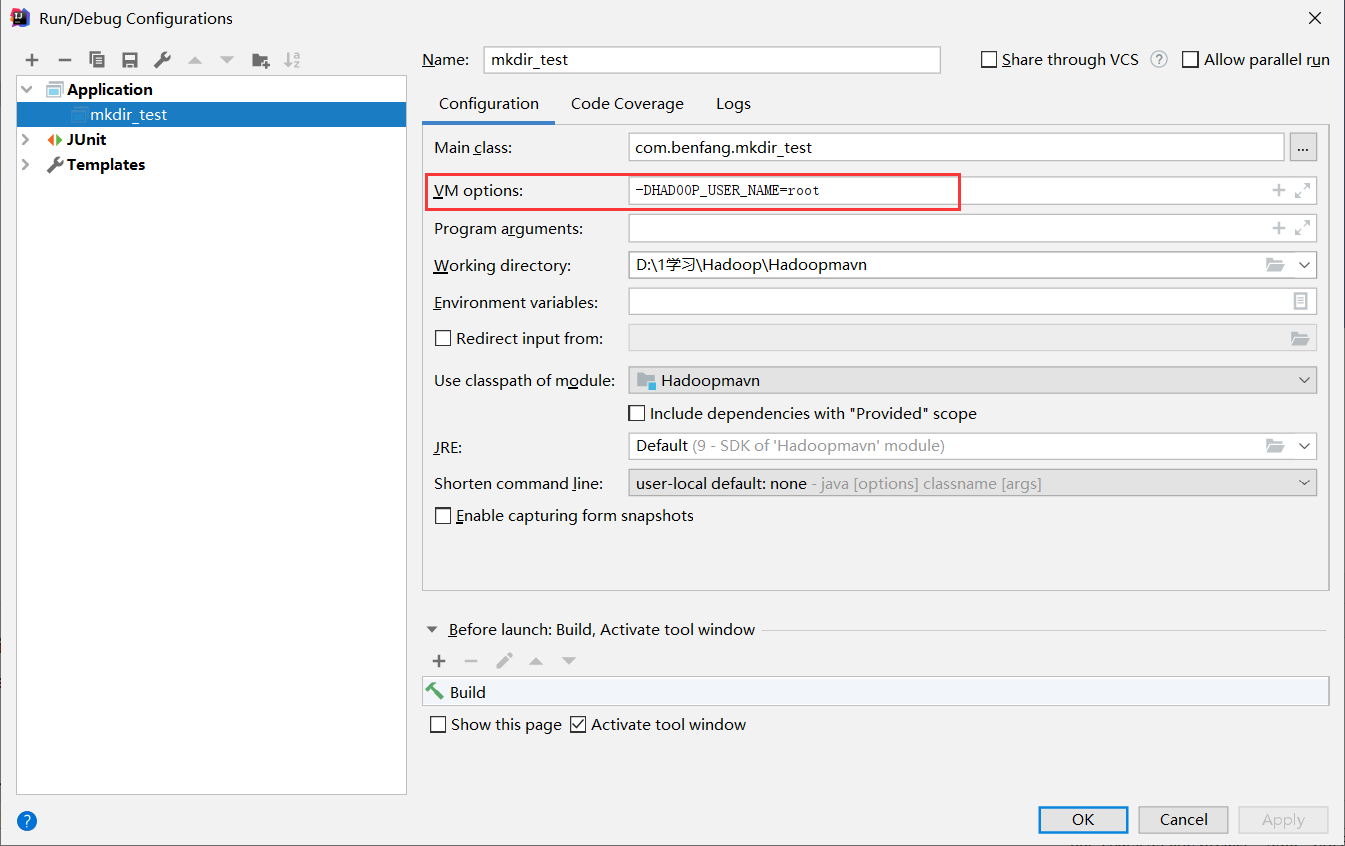

运行之前先配置一下。

找到RUN-edit Configuartions….

YM options:选项写上-DHADOOP_USER_NAME=root

果不配置这个YM options:的话会报权限错误。

解决了后:我们去运行。

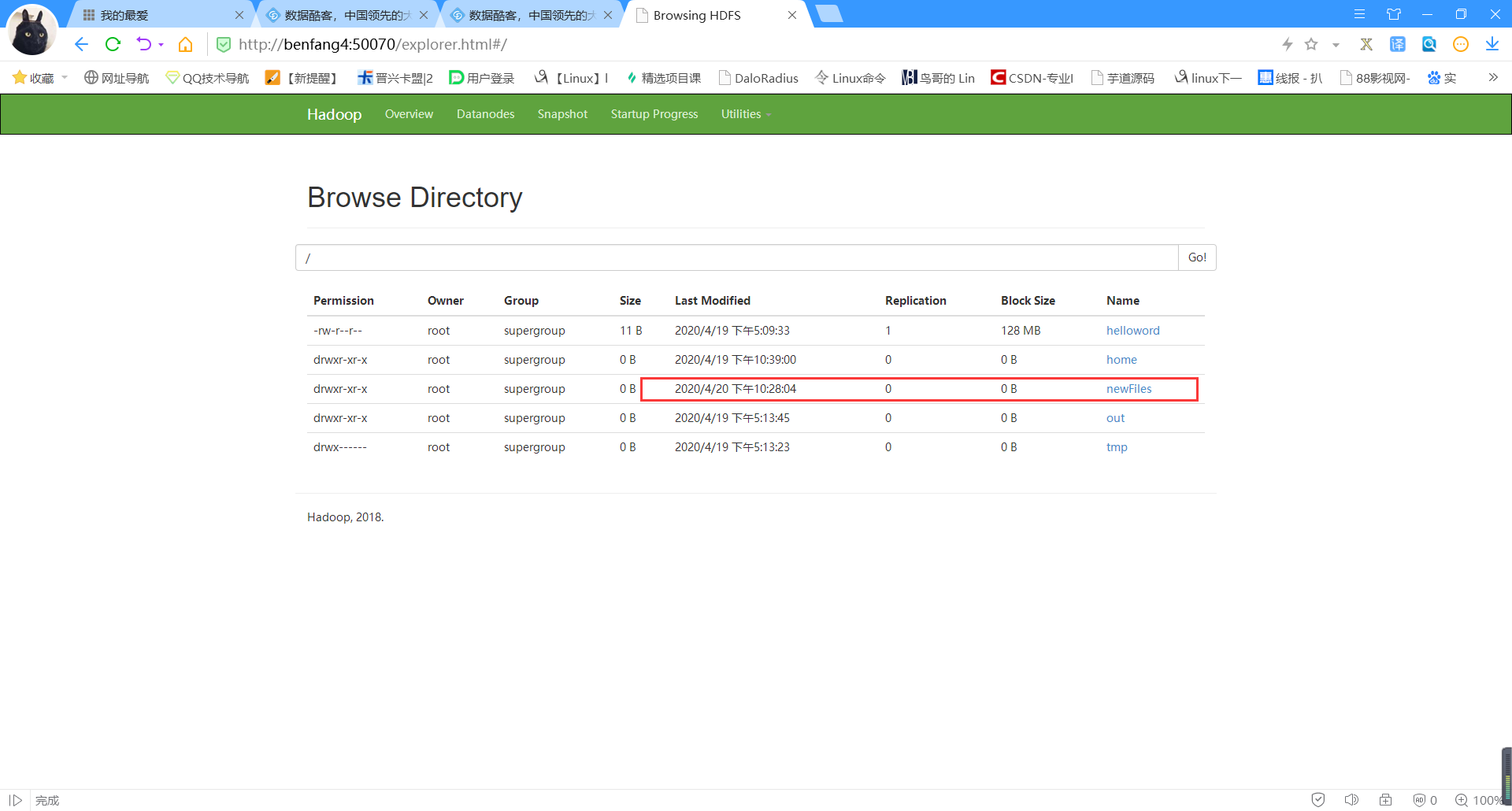

然后去50070查看一下。

问题: 如果报错无效的maven发行版本的话

记得检查,maven版本是否正确。 这个版本是java版本,别问我为什么我也不知道。