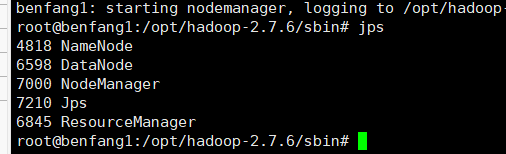

Hadoop 启动后使用JPS查看没有DataNode

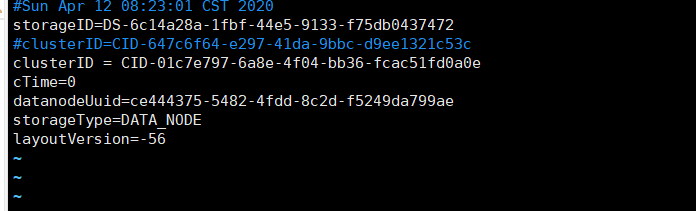

排除hdfs.site.xml本身配置错的问题的话可能是

一般由于多次格式化NameNode导致。在配置文件中保存的是第一次格式化时保存的namenode的ID,因此就会造成datanode与namenode之间的id不一致。

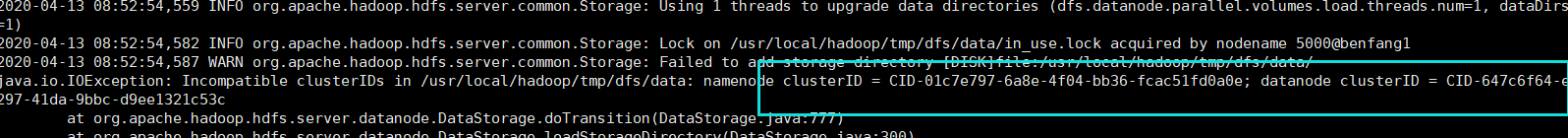

为了更好的定位问题在这里我建议大家去,Hadoop目录下面去logs文件夹去查看日志信息。

果然。。是clusterid不匹配的问题

报错信息我给大家翻译一下

WARN org.apache.hadoop.hdfs.server.common.Storage:无法添加存储目录[DISK]文件:/ usr / local / hadoop / tmp / dfs / data /

java.io.IOException:/ usr / local / hadoop / tmp / dfs / data中不兼容的clusterID:namenode clusterID = CID-01c7e797-6a8e-4f04-bb36-fcac51fd0a0e; 数据节点clusterID = CID-647c6f64-e297-41da-9bbc-d9ee1321c53c

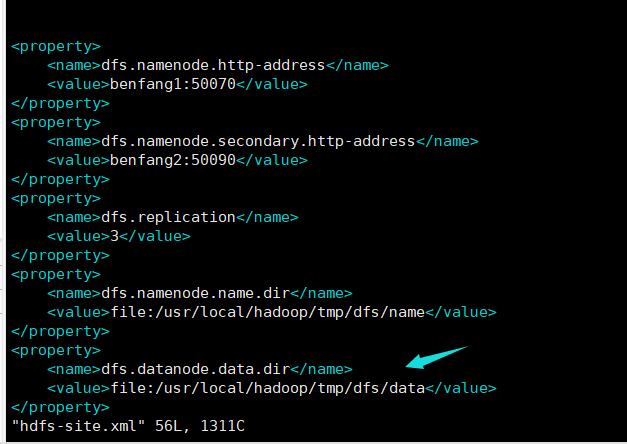

解决方法 先去hdfs-site.xml看看datanode的位置

找到data目录,在这个目录下,有一个VERSION文件。将VERSION中的clusterID改成上面复制的ID。

重启服务。 jps一下

美滋滋成功。